Hyper-V Passthrough PCIe NVMe SSD

Hallo zusammen!

Da mir letztes mal schon so toll geholfen bzw beraten wurde, habe ich gleich eine weitere Frage.

Da mir im letzten Thread geraten wurde, meine Infrastruktur zu "schrumpfen" und mehr zu virtualisieren, benötige ich nun Auskunft zum Thema PCIe passthrough.

Es geht um einen künftigen HyperV Host, auf dem ein Fileserver virtualisiert werden soll.

An den Fileserver sollen sechs NVMe-Laufwerke durchgereicht werden.

Ist das ohne weiteres möglich?

Kann ich das gleich handhaben, wie bei einem "normalen" SATA-Datenträger? Oder muss das ähnlich wie bei Grafikkarten über die Powershell, sow wie hier im Blogbeitrag beschrieben

Blogbeitrag PCIe Pasthrough

Wenn beides möglich sein sollte, gibt es Vor oder Nachteile von einer zur anderen Möglichkeit?

Grüße und schönes Wochenende!

Da mir letztes mal schon so toll geholfen bzw beraten wurde, habe ich gleich eine weitere Frage.

Da mir im letzten Thread geraten wurde, meine Infrastruktur zu "schrumpfen" und mehr zu virtualisieren, benötige ich nun Auskunft zum Thema PCIe passthrough.

Es geht um einen künftigen HyperV Host, auf dem ein Fileserver virtualisiert werden soll.

An den Fileserver sollen sechs NVMe-Laufwerke durchgereicht werden.

Ist das ohne weiteres möglich?

Kann ich das gleich handhaben, wie bei einem "normalen" SATA-Datenträger? Oder muss das ähnlich wie bei Grafikkarten über die Powershell, sow wie hier im Blogbeitrag beschrieben

Blogbeitrag PCIe Pasthrough

Wenn beides möglich sein sollte, gibt es Vor oder Nachteile von einer zur anderen Möglichkeit?

Grüße und schönes Wochenende!

Please also mark the comments that contributed to the solution of the article

Content-Key: 62594030061

Url: https://administrator.de/contentid/62594030061

Printed on: April 27, 2024 at 23:04 o'clock

25 Comments

Latest comment

Da ich nicht weiß, wie performant ein Fileserver unter Windows mit NVMe-SSDs ist, wolle ich auf den Versuch verzichten.

<ironie>

Es wird grottenlangsam sein, und vor allem die Latenzen werden scih im gigantischen Mikrosekundenbereich bewegen.... um eine Million Dateien zu zählen wird man die wahnsinnige Zeit von ca. 30 Sekunden warten müssen. Um 100 GB zu kopieren muß man dann auch wahnsinnig lange 100 Sekunden warten. Ich würde das lieber mit mechanischen Festplatten machen, am besten nur eine mit 20 TB oder so... lieber Millisekunden an Latenzen und vorzugsweise weniger als 120 Megabyte pro Sekunde

</ironie>

<ironie>

Es wird grottenlangsam sein, und vor allem die Latenzen werden scih im gigantischen Mikrosekundenbereich bewegen.... um eine Million Dateien zu zählen wird man die wahnsinnige Zeit von ca. 30 Sekunden warten müssen. Um 100 GB zu kopieren muß man dann auch wahnsinnig lange 100 Sekunden warten. Ich würde das lieber mit mechanischen Festplatten machen, am besten nur eine mit 20 TB oder so... lieber Millisekunden an Latenzen und vorzugsweise weniger als 120 Megabyte pro Sekunde

</ironie>

Das heißt du willst TrueNAS als VM laufen lassen und dort die NVMEs dann durchreichen?

Also mit Hyper-V kenne ich mich nicht aus, aber mit Proxmox läuft das ohne Probleme.

Ansonsten könntest du noch TrueNAS eigenständig als Server laufen lassen und deinem Hypervisor (Hyper-V) dann den "Storage" zuweisen bzw. benutzen lassen. Ob jetzt per NFS, SMB oder sonstige Funktionen ist ja egal.

Also mit Hyper-V kenne ich mich nicht aus, aber mit Proxmox läuft das ohne Probleme.

Ansonsten könntest du noch TrueNAS eigenständig als Server laufen lassen und deinem Hypervisor (Hyper-V) dann den "Storage" zuweisen bzw. benutzen lassen. Ob jetzt per NFS, SMB oder sonstige Funktionen ist ja egal.

Hi,

Ob man die NVMEs direkt an eine VM durchreichen kann, weiß ich ehrlich gesagt nicht.

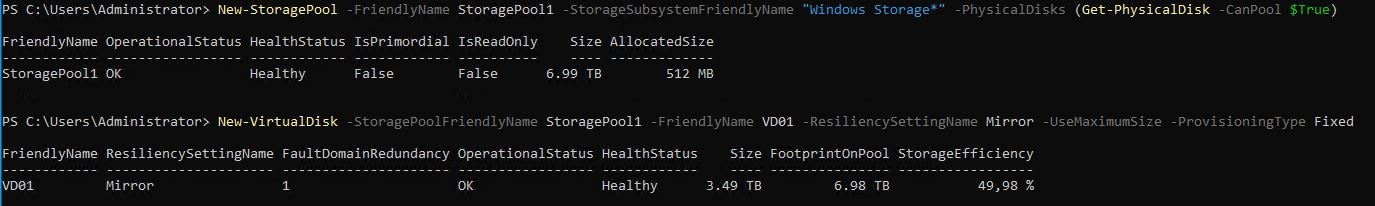

Ich würde auf dem HyperV standalone Server auch Mal eine Basis erstellen und darauf dann die vhdx.

storage spaces

Mit NVMEs hast du sowieso mehr als genug Performance.

Ob man die NVMEs direkt an eine VM durchreichen kann, weiß ich ehrlich gesagt nicht.

Ich würde auf dem HyperV standalone Server auch Mal eine Basis erstellen und darauf dann die vhdx.

storage spaces

Mit NVMEs hast du sowieso mehr als genug Performance.

Moin @enkay666,

das ist bei einem Software RAID und vor allem bei Windows leider nichts unnatürliches.

Wenn du wirklich gute Storageperformance, vor allem unter Windows benötigst, dann führt fürchte ich kein Weg an einem Hardware-RAID-Controller vorbei. 😔

Gruss Alex

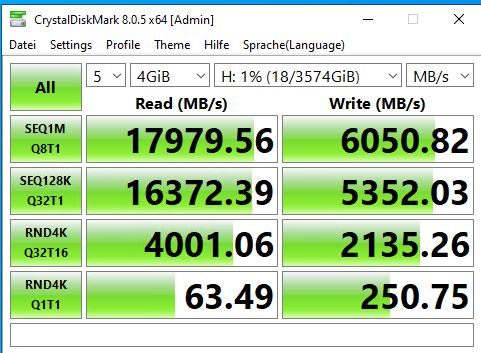

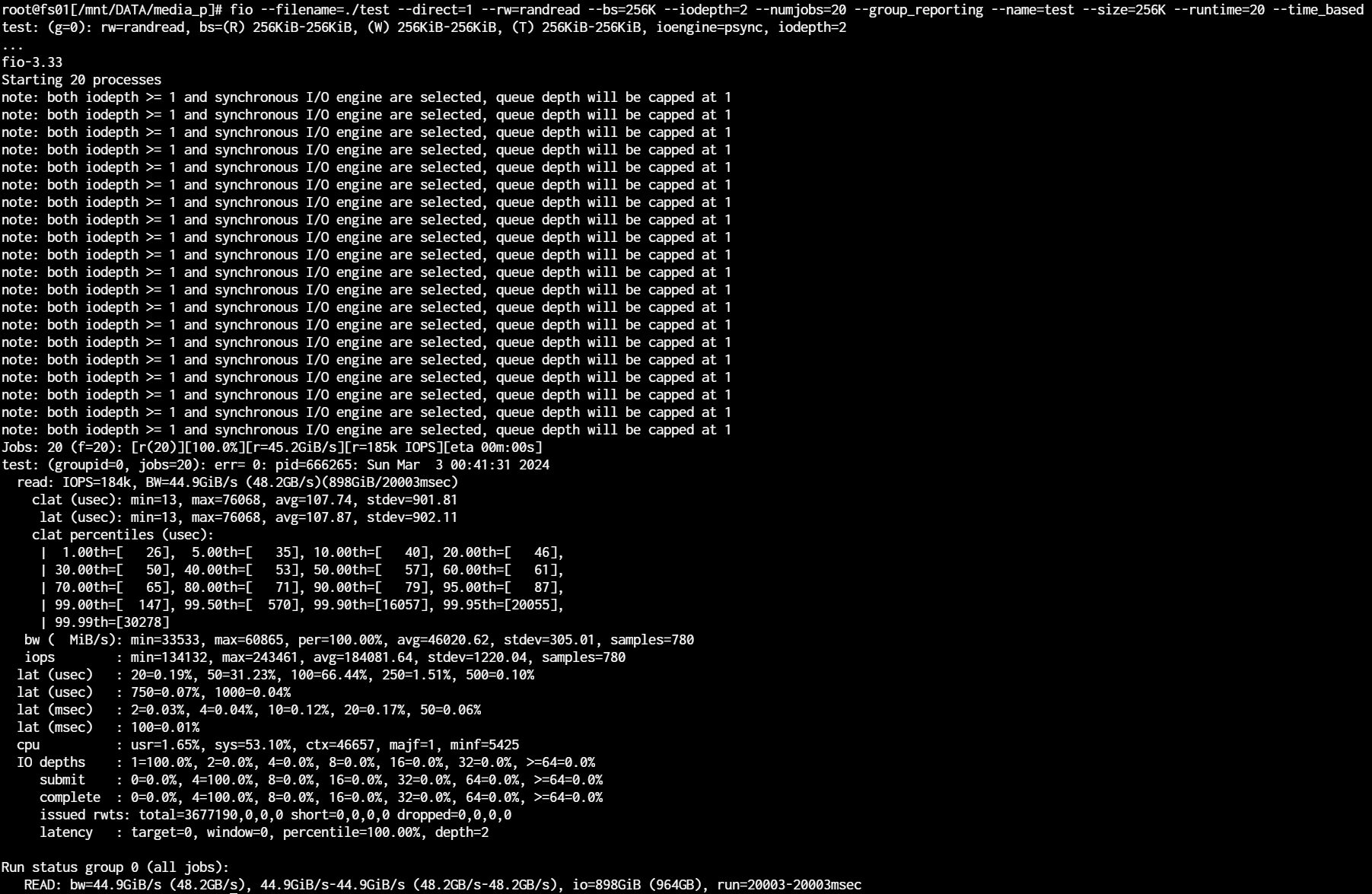

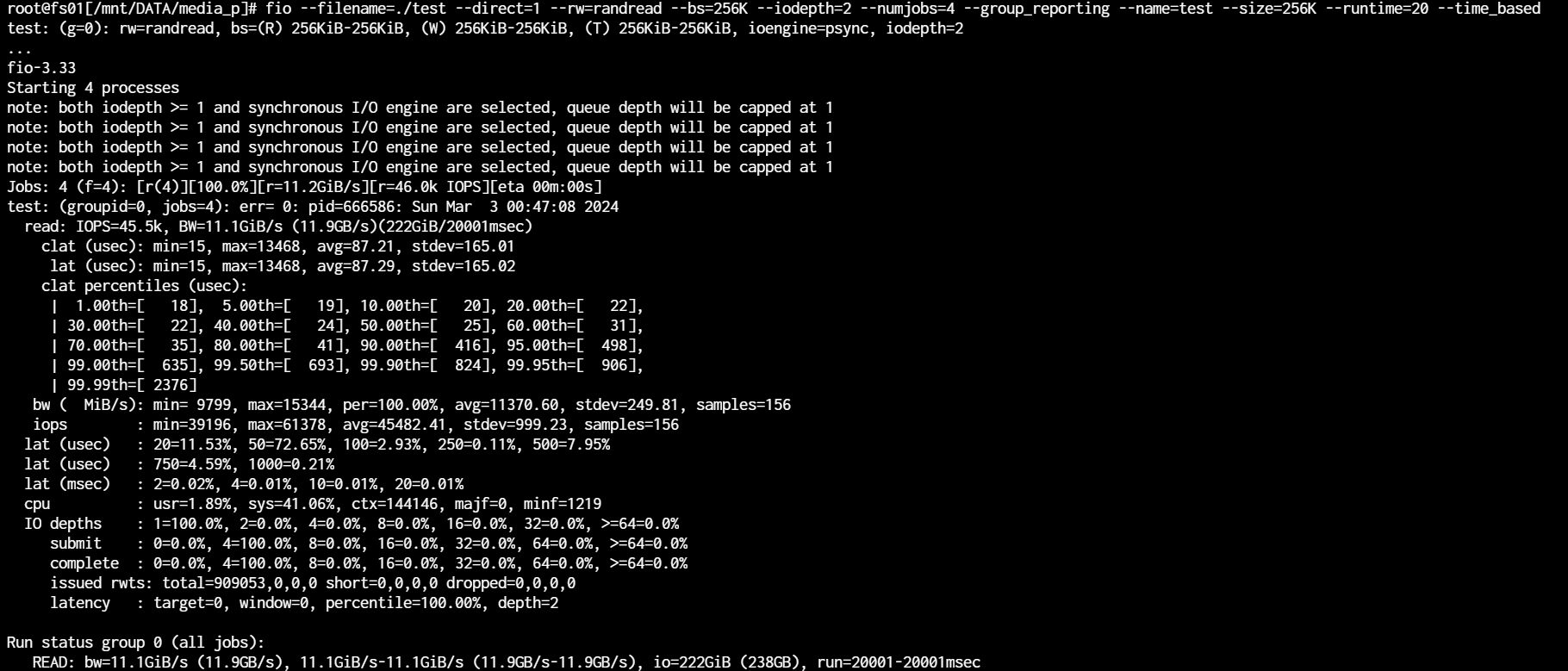

habe es heute mittag mal durchgespielt. Storage-Pool unter WinServer2022 erstellt, als Parität, und das Resultat:

19GB/s lesend (sequenziell) und schreiben völlig unterirdische 300-500MB/s

Da stimmt doch was nicht?

19GB/s lesend (sequenziell) und schreiben völlig unterirdische 300-500MB/s

Da stimmt doch was nicht?

das ist bei einem Software RAID und vor allem bei Windows leider nichts unnatürliches.

Wenn du wirklich gute Storageperformance, vor allem unter Windows benötigst, dann führt fürchte ich kein Weg an einem Hardware-RAID-Controller vorbei. 😔

Gruss Alex

Moin @enkay666,

jup, daher kann mir auch S2D & Co. höchstens mal den Buckel ra rutschen.

Und wie hast du die SSD's an das TrueNAS nun durchgereicht?

Gruss Alex

das ist mehr als beschämend!

jup, daher kann mir auch S2D & Co. höchstens mal den Buckel ra rutschen.

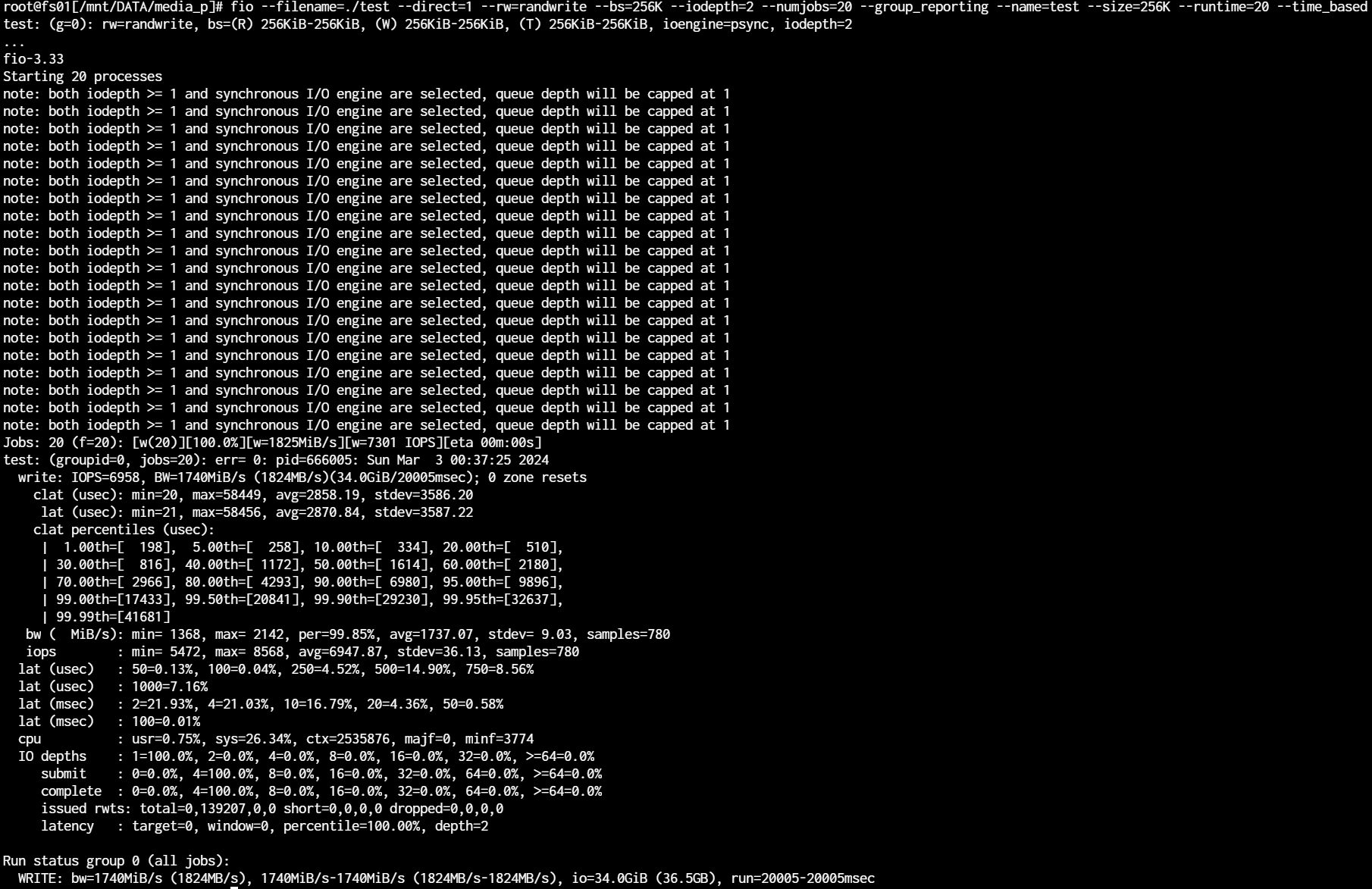

habe nun eine VM mit dem zuvor schon genutzten TrueNAS aufgesetzt und die Ergebnisse können sich sehen lassen. Schreibend (ohne Ramcache natürlich!) ca. 15GB/s und lesend etwas über 5GB. Da mir die Performance beim Schreiben sehr viel wichtiger ist, sind die 5GB/s lesen kein Problem in meinem Fall

Und wie hast du die SSD's an das TrueNAS nun durchgereicht?

Gruss Alex

Moin @enkay666,

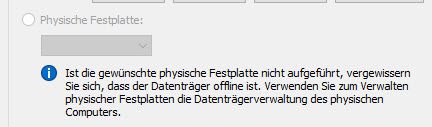

sprich, du hast die SSD's einzeln als "Physische Festplatte" ...

... an die TrueNAS-VM durchgereicht, richtig?

Gruss Alex

Regulär, wie eine normale HDD oder SSD auch, eingebunden per SCSI-Controller unter den VM-Einstellungen.

sprich, du hast die SSD's einzeln als "Physische Festplatte" ...

... an die TrueNAS-VM durchgereicht, richtig?

Gruss Alex

Moin @enkay666,

du hast also das Software RAID nicht über das Windows sondern über die VM mit Linux (TrueNAS) realisiert und hast nun in der VM eine deutlich bessere Storageperformance als mit dem Storage-Pool von Windows.

Korrekt?

Gruss Alex

ganz genau

du hast also das Software RAID nicht über das Windows sondern über die VM mit Linux (TrueNAS) realisiert und hast nun in der VM eine deutlich bessere Storageperformance als mit dem Storage-Pool von Windows.

Korrekt?

Gruss Alex

Moin @enkay666,

also, ich fass mal zusammen.

Mit "Storage-Pools", also mit dem hauseigenen Software-RAID von Windows erreichst du schreiben völlig unterirdische 300-500MB/s obwohl die SSD's in dem Fall über NVME angesprochen werden.

Und auf einer VM mit einem "TrueNAS" erreichst du Schreibend (ohne Ramcache natürlich!) ca. 15GB/s, obwohl der Zugriff auf die SSD's nicht nativ per NVME erfolgt.

Ähm ... @microsoft

😂🤣😂🤣 🙈 und genau wegen sowas kann mir euer S2D auch weiterhin höchstens mal den Buckel ra rutschen.

Nur der Neugierde halber, wie viele vCores hast du der TrueNAS VM gegeben und wie viele Cores gibt die Hardware her?

Gruss Alex

richtig. Als Alternative gäbe es noch die Möglichkeit, die PCIe-SSDs direkt durchzureichen, also eben als PCIe-Gerät, ähnlich wie beim GPU-Passthrough.

also, ich fass mal zusammen.

Mit "Storage-Pools", also mit dem hauseigenen Software-RAID von Windows erreichst du schreiben völlig unterirdische 300-500MB/s obwohl die SSD's in dem Fall über NVME angesprochen werden.

Und auf einer VM mit einem "TrueNAS" erreichst du Schreibend (ohne Ramcache natürlich!) ca. 15GB/s, obwohl der Zugriff auf die SSD's nicht nativ per NVME erfolgt.

Ähm ... @microsoft

😂🤣😂🤣 🙈 und genau wegen sowas kann mir euer S2D auch weiterhin höchstens mal den Buckel ra rutschen.

Wenn ich irgendwann mal viel Zeit habe, versuch ich das vielleicht auch mal.

Nur der Neugierde halber, wie viele vCores hast du der TrueNAS VM gegeben und wie viele Cores gibt die Hardware her?

Gruss Alex

Moin @enkay666,

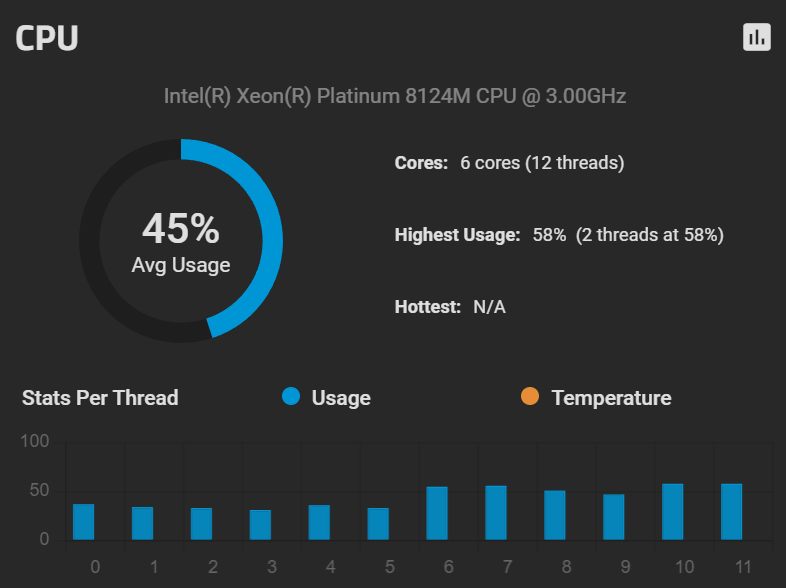

das Blech hat folgende Hardware:

das macht die Sache nicht wirklich besser, im Gegenteil, damit macht sich Microsoft nur noch lächerlicher.

Denn 15GB/s schreibend mit "nur" 12 Virtual-Cores, gegen 300-500MB/s mit 38 Physical-Cores ist schon eine Hausnummer. 😔

@microsoft

🙈🙈🙈

@enkay666

Hast du bei dem Test mit dem "Storage-Pool" rein zufällig die CPU Auslastung beobachtet?

Gruss Alex

Nur der Neugierde halber, wie viele vCores hast du der TrueNAS VM gegeben und wie viele Cores gibt die Hardware her?

die VM hat zugewiesen bekommen:- 12 virtuelle Prozessoren

- 32GB Ram

- 6x Datenträger (als physisch durchgereicht)

das Blech hat folgende Hardware:

- 2x Xeon Platinum 8124M (18x 3,0GHz je CPU)

- 96 GB RAM (2400MHz, 48GB je CPU, hexachannel)

- 2x SATA SSD für Bootpartition

- 6x Kioxia 3,84TB CD6 (KCD61LUL3T84)

das macht die Sache nicht wirklich besser, im Gegenteil, damit macht sich Microsoft nur noch lächerlicher.

Denn 15GB/s schreibend mit "nur" 12 Virtual-Cores, gegen 300-500MB/s mit 38 Physical-Cores ist schon eine Hausnummer. 😔

@microsoft

🙈🙈🙈

@enkay666

Hast du bei dem Test mit dem "Storage-Pool" rein zufällig die CPU Auslastung beobachtet?

Gruss Alex

Moin @enkay666,

genau so ist das, den bei RAID 1 muss kein Parity berechnet werden.

Ausserdem hat MS vor etwa zwei bis drei Jahren im Storage-Stack eh irgend einen Mist eingebaut den ich noch nicht gefunden habe, denn seit dem bringt meine eigenen Workstation storagetechnisch nur noch knapp 50% der vorherigen Leistung. 😭

Gruss Alex

der Vergleich hinkt etwas, da du ein two-way-mirror mit einem RAID5 vergleichst.

genau so ist das, den bei RAID 1 muss kein Parity berechnet werden.

Ausserdem hat MS vor etwa zwei bis drei Jahren im Storage-Stack eh irgend einen Mist eingebaut den ich noch nicht gefunden habe, denn seit dem bringt meine eigenen Workstation storagetechnisch nur noch knapp 50% der vorherigen Leistung. 😭

Gruss Alex