Cisco Nexus config für vmware und Proxmox

Hi,

Ich hänge gerade an einem vermutlich banalen Problem.

Also bisher habe ich gelernt:

vmware vswitch an Cisco Nexus vpc mit zwei Ports: beide Ports auf dem host dem vswitch zuordnen und als trunk aber nicht als etherchanel konfigurieren. Korrekt? Wenn ja, was passiert dort? Nach meinem Verständnis müsste ich einen lacp portchanel konfigurieren, allerdings ist mir das schon einmal um die Ohren geflogen. Ein Netzwerkkabel hat dafür gesorgt das ein Port von 10g auf 1g sprang und daraufhin wurde wegen Konfig mismatch der zweite Port disabled was doof war da iscsi. Daraufhin sagte unser externer Berater keine portchanel konfigurieren, das regelt vmware und Cisco untereinander.

Nun baue ich gerade einen Proxmox Cluster. Bei dem würde ich ja ein Bond bauen mit lacp, korrekt? Muss ich hier nun auf dem Cisco Nexus einen lacp portchanel bauen? Ich gehe davon aus, dass vmware auch lacp passiv macht und der scheint ohne portchanel besser zu funktionieren als mit.

Vielen lieben Dank für die Unterstützung

Ich hänge gerade an einem vermutlich banalen Problem.

Also bisher habe ich gelernt:

vmware vswitch an Cisco Nexus vpc mit zwei Ports: beide Ports auf dem host dem vswitch zuordnen und als trunk aber nicht als etherchanel konfigurieren. Korrekt? Wenn ja, was passiert dort? Nach meinem Verständnis müsste ich einen lacp portchanel konfigurieren, allerdings ist mir das schon einmal um die Ohren geflogen. Ein Netzwerkkabel hat dafür gesorgt das ein Port von 10g auf 1g sprang und daraufhin wurde wegen Konfig mismatch der zweite Port disabled was doof war da iscsi. Daraufhin sagte unser externer Berater keine portchanel konfigurieren, das regelt vmware und Cisco untereinander.

Nun baue ich gerade einen Proxmox Cluster. Bei dem würde ich ja ein Bond bauen mit lacp, korrekt? Muss ich hier nun auf dem Cisco Nexus einen lacp portchanel bauen? Ich gehe davon aus, dass vmware auch lacp passiv macht und der scheint ohne portchanel besser zu funktionieren als mit.

Vielen lieben Dank für die Unterstützung

Please also mark the comments that contributed to the solution of the article

Content-Key: 7657958412

Url: https://administrator.de/contentid/7657958412

Printed on: May 3, 2024 at 23:05 o'clock

9 Comments

Latest comment

Hi

Das war schon mal der erste große Fehler! Bei iscsi macht man kein LCAP.

LACP mit ESXI funktioniert auch nur mit der Enterprise Version von VMware und Distributed Switches.

Nachzulesen hier LACP-Support auf einem vSphere Distributed Switch

Daraufhin sagte unser externer Berater keine portchanel konfigurieren, das regelt vmware und Cisco untereinander.

Da hat er dir nur die halbe Wahrheit gesagt. Bezogen auf die VMware Standard Switches und der Default config, welches jeder "Admin" hinbekommt.

VM Anbindung oder Storage? Auch hier gilt....bei iscsi kein LACP.

Gruß

Zitat von @matzefratze81:

Hi,

Ich hänge gerade an einem vermutlich banalen Problem.

Also bisher habe ich gelernt:

vmware vswitch an Cisco Nexus vpc mit zwei Ports: beide Ports auf dem host dem vswitch zuordnen und als trunk aber nicht als etherchanel konfigurieren. Korrekt? Wenn ja, was passiert dort? Nach meinem Verständnis müsste ich einen lacp portchanel konfigurieren, allerdings ist mir das schon einmal um die Ohren geflogen. Ein Netzwerkkabel hat dafür gesorgt das ein Port von 10g auf 1g sprang und daraufhin wurde wegen Konfig mismatch der zweite Port disabled was doof war da iscsi.

Hi,

Ich hänge gerade an einem vermutlich banalen Problem.

Also bisher habe ich gelernt:

vmware vswitch an Cisco Nexus vpc mit zwei Ports: beide Ports auf dem host dem vswitch zuordnen und als trunk aber nicht als etherchanel konfigurieren. Korrekt? Wenn ja, was passiert dort? Nach meinem Verständnis müsste ich einen lacp portchanel konfigurieren, allerdings ist mir das schon einmal um die Ohren geflogen. Ein Netzwerkkabel hat dafür gesorgt das ein Port von 10g auf 1g sprang und daraufhin wurde wegen Konfig mismatch der zweite Port disabled was doof war da iscsi.

Das war schon mal der erste große Fehler! Bei iscsi macht man kein LCAP.

LACP mit ESXI funktioniert auch nur mit der Enterprise Version von VMware und Distributed Switches.

Nachzulesen hier LACP-Support auf einem vSphere Distributed Switch

Daraufhin sagte unser externer Berater keine portchanel konfigurieren, das regelt vmware und Cisco untereinander.

Da hat er dir nur die halbe Wahrheit gesagt. Bezogen auf die VMware Standard Switches und der Default config, welches jeder "Admin" hinbekommt.

Nun baue ich gerade einen Proxmox Cluster. Bei dem würde ich ja ein Bond bauen mit lacp, korrekt?

Was ist denn dein Ziel?VM Anbindung oder Storage? Auch hier gilt....bei iscsi kein LACP.

Gruß

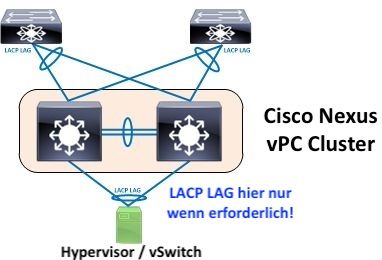

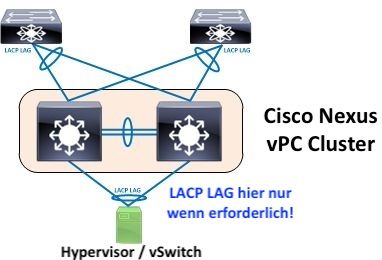

Auch nach 3maligem Lesen ist leider nicht wirklich klar wie dein Design aussehen soll.

OK, es geht irgendwie um einen Nexus vPC an einen vSwitch soviel ist klar. Nur das WIE ist wirr und unklar.

Generell ist ein vPC also virtueller Port Channel bzw. Etherchannel (Etherchannel sind LACP LAGs im Cisco Sprachgebrauch!) nichts anderes als ein MLAG. Siehe Details dazu HIER.

Du wirfst hier also wirr ziemlich viel durcheinander und man kann nicht genau sagen was deine eigentliche Zielsetzung ist. Eine kleine Topologieskizze würde sicher helfen hier.

Dein externer "Berater" hat Recht und Unrecht zugleich.

Unrecht hat er das Cisco und VmWare etwas "regeln". Beide Seiten verstehen zwar das Cisco Infrastrukturprotokoll CDP (Cisco Discovery Protokoll) und "sehen" jeweils die andere Seite, das wars dann aber auch schon.

Recht hat er das (VmWare) Hypervisor bei multiplen, parallelen Links in der Regel keinen LACP LAG nutzen sondern der vSwitch von sich aus die virtuellen Mac Adressen der VMs automatisch auf Mehrfachlinks balanced und es eine L2 Trennung zw. den Interfaces gibt (Loop Protection). Als Fazit daraus kommt man also ohne LACP LAGs aus und steckt NICs einfach parallel in ein VM VLAN und gut ist. Bei einem Nexus Cluster dann natürlich Switch übergreifend weil man hier natürlich wieder die Redndanz haben will.

LACP LAGs bzw. MLAGs kann Sinn machen in bestimmten Designs. Dazu müsste man deins aber erstmal genau verstehen...

OK, es geht irgendwie um einen Nexus vPC an einen vSwitch soviel ist klar. Nur das WIE ist wirr und unklar.

- vPC bei Nexus bedeutet ja erstmal immer zwei Nexus Switches die in einem vPC Cluster (Redundanz) laufen! Ob das bei dir der Fall ist bleibt schleierhaft?

- In so einem klassischen vPC Design nimmt man immer einen Etherchannel Memberlink vom Nexus 1 und einen vom Nexus 2 den man dann auf dem Zielswitch (in deinem Falle der vSwitch) terminiert. Klar, denn man will ja immer die Geräteredundanz UND die Linkredundanz haben in so einem HA Design. Ist das so gemeint?

Generell ist ein vPC also virtueller Port Channel bzw. Etherchannel (Etherchannel sind LACP LAGs im Cisco Sprachgebrauch!) nichts anderes als ein MLAG. Siehe Details dazu HIER.

Du wirfst hier also wirr ziemlich viel durcheinander und man kann nicht genau sagen was deine eigentliche Zielsetzung ist. Eine kleine Topologieskizze würde sicher helfen hier.

Dein externer "Berater" hat Recht und Unrecht zugleich.

Unrecht hat er das Cisco und VmWare etwas "regeln". Beide Seiten verstehen zwar das Cisco Infrastrukturprotokoll CDP (Cisco Discovery Protokoll) und "sehen" jeweils die andere Seite, das wars dann aber auch schon.

Recht hat er das (VmWare) Hypervisor bei multiplen, parallelen Links in der Regel keinen LACP LAG nutzen sondern der vSwitch von sich aus die virtuellen Mac Adressen der VMs automatisch auf Mehrfachlinks balanced und es eine L2 Trennung zw. den Interfaces gibt (Loop Protection). Als Fazit daraus kommt man also ohne LACP LAGs aus und steckt NICs einfach parallel in ein VM VLAN und gut ist. Bei einem Nexus Cluster dann natürlich Switch übergreifend weil man hier natürlich wieder die Redndanz haben will.

LACP LAGs bzw. MLAGs kann Sinn machen in bestimmten Designs. Dazu müsste man deins aber erstmal genau verstehen...

Moin,

Die VMware Lösung ist aus Netzwerk Sicht ein graus. Das mag ja alles funktionieren. Sobald aber Kabel gezogen wird sind die VMs strubbelig.

Ich bin daher froh jetzt alles mit Distri Switchenbam laufen zu haben.

Wichtig - kein IP-hash nutzen. IP-hash nur ohne LACP.

Bei Proxmox geht eh nix anderes als LACP oder einzel Link.

Gruß

Spirit

Die VMware Lösung ist aus Netzwerk Sicht ein graus. Das mag ja alles funktionieren. Sobald aber Kabel gezogen wird sind die VMs strubbelig.

Ich bin daher froh jetzt alles mit Distri Switchenbam laufen zu haben.

Wichtig - kein IP-hash nutzen. IP-hash nur ohne LACP.

Bei Proxmox geht eh nix anderes als LACP oder einzel Link.

Gruß

Spirit

"Richtiges vPC" (LACP MLAG) sieht dann am Cisco Nexus in der Grundkonfig so aus:

Nexus-2 sieht dann genau analog zur obigen Konfig aus.

Wie die vSwitches unter VmWare und Promox dann die Uplinks handeln kannst du u.a. HIER und HIER nachlesen.

feature lacp

feature vpc

feature lldp

clock timezone CET 1 0

clock summer-time CEST recurring last Sun Mar 2:00 last Sun Oct 3:00

!

vlan 1

name Management

vlan 10

name VMs

vlan 20

name Clients

vlan 100

name WLAN

!

vpc domain 10

peer-switch

auto-recovery

peer-keepalive destination 10.1.1.2 source 10.1.1.1

!

interface port-channel1

description vPC Link

mtu 9216

switchport mode trunk

spanning-tree port type network

vpc peer-link

!

interface port-channel 20

description Member LAG

switchport mode trunk

mtu 9216

vpc 20

!

interface Ethernet1/49

description vPC Link

mtu 9216

switchport mode trunk

channel-group 1 mode active

!

interface Ethernet1/50

description vPC Link

mtu 9216

switchport mode trunk

channel-group 1 mode active

!

interface ethernet 1/1

description LACP Member Link

mtu 9216

switchport mode trunk

channel-group 20 mode active

!

interface mgmt0

vrf member management

ip address 10.1.1.1/24

Nexus-1# sh vpc role

vPC Role status

----------------------------------------------------

vPC role : primary

Dual Active Detection Status : 0

vPC system-mac : 00:23:04:ee:ae:16

vPC system-priority : 32667

vPC local system-mac : 00:3a:9c:1d:ae:16

vPC local role-priority : 32667

vPC local config role-priority : 32667

vPC peer system-mac : 00:3a:9c:21:be:1f

vPC peer role-priority : 32667

vPC peer config role-priority : 32667

Nexus-1# sh vpc

Legend:

(*) - local vPC is down, forwarding via vPC peer-link

vPC domain id : 10

Peer status : peer adjacency formed ok

vPC keep-alive status : peer is alive

Configuration consistency status : success

Per-vlan consistency status : success

Type-2 consistency status : success

vPC role : primary

Number of vPCs configured : 0

Peer Gateway : Disabled

Dual-active excluded VLANs : -

Graceful Consistency Check : Enabled

Auto-recovery status : Disabled

Delay-restore status : Timer is off.(timeout = 30s)

Delay-restore SVI status : Timer is off.(timeout = 10s)

Operational Layer3 Peer-router : Disabled

vPC Peer-link status

---------------------------------------------------------------------

id Port Status Active vlans

-- ---- ------ -------------------------------------------------

1 Po1 up 1,10,20,100 Nexus-2 sieht dann genau analog zur obigen Konfig aus.

Wie die vSwitches unter VmWare und Promox dann die Uplinks handeln kannst du u.a. HIER und HIER nachlesen.

@aqui

Zu der Konfiguration habe eine Frage.

Das ist der peer-link zwischen den zwei Nexus Switchen

Das hier ist für keepalive(Heartbeat)

Das ist der Member Link

Fehlt da nicht noch ein:

Oder gebe ich den vPC nur mit, wenn ich mehrere vPC Domains habe??

Zu der Konfiguration habe eine Frage.

Das ist der peer-link zwischen den zwei Nexus Switchen

interface port-channel1

description vPC Link

mtu 9216

switchport mode trunk

spanning-tree port type network

vpc peer-linkDas hier ist für keepalive(Heartbeat)

interface mgmt0

vrf member management

ip address 10.1.1.1/24Das ist der Member Link

interface Ethernet1/50

description vPC Link

mtu 9216

switchport mode trunk

channel-group 1 mode activeFehlt da nicht noch ein:

vpc 10Oder gebe ich den vPC nur mit, wenn ich mehrere vPC Domains habe??