Erste Gehversuche 10GBit - bitte um Eure Erfahrung

Hallo,

ich möchte in meinem kleinen Netz die Hyper-V Hosts mit dem QNAP-NAS und dem Backupserver via 10GBit verbinden.

Die Arbeitsplätze selbst bleiben auf 1GB, das reicht i.A.

Bevor ich das nun nachrüste habe ich eine Teststellung aufgebaut:

NIC: ASUS XG-C100C mit aktuellstem Treiber von der Chiphomepage - ja ich weiß das ist kein Intel, was ich darüber aber gelesen hatte war vielversprechend. Es gibt Alternativen von Synology (E10G18-T1) oder Intel (X540), aber ich hatte nicht vor einen Riesentestbench aufzubauen.

Switch: Netgear XS708E, 8-Port 10GB

Verkabelung: CAT7 TP

Teststellung: 2 moderne PCs mit je einer ASUS-Karte verbunden mit dem Netgear, der wiederum mit einem Kabel auf einem Standard-GBit hängt um den Rest des Netzes zu erreichen / DHCP / ..

Ich tue mich nun sehr schwer den Durchsatz real zu bewerten.

Das Testtool 'Lanspeedtest' arbeitet in der Free-Version nicht zuverlässig und bevor ich das kaufe, wüsste ich gern ob es denn dann funktioniert.

"Netstress" hat eine Menge PArameter an denen ich drehen kann, ich bräuchte dafür aber sowas wie einen sinnigen PreSet für 10GB um das auswerten zu können.

SMB über FileCopy zwischen den PCs ist zu verwaschen, da gehen Befindlichkeiten von Windows und dessen Subsystem zu sehr ein.

Bottom Line erreiche ich bestenfalls 2GBit Durchsatz (mit obigen Tools zusammengewürfelt), aber das ist sehr unsicher.

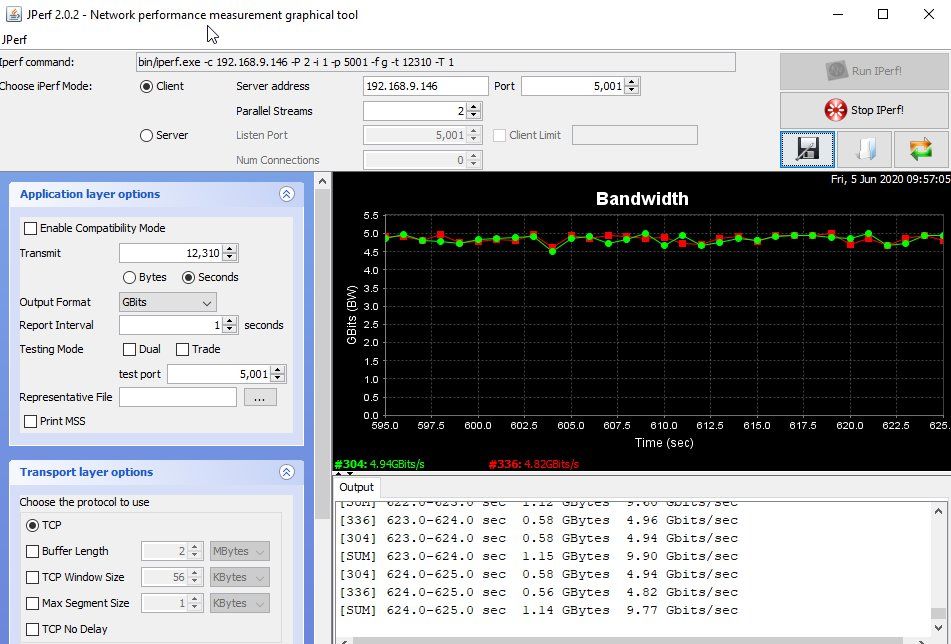

IPERF/JPERF sind schon aussagekräftiger, ich komme aber auch hier nicht über 4GB

An den IP-Parametern zu drehen (Jumbo etc.) ist nicht sinnig ohne exakt zu wissen was was bringt.

Danke Euch vorab für den Input

ich möchte in meinem kleinen Netz die Hyper-V Hosts mit dem QNAP-NAS und dem Backupserver via 10GBit verbinden.

Die Arbeitsplätze selbst bleiben auf 1GB, das reicht i.A.

Bevor ich das nun nachrüste habe ich eine Teststellung aufgebaut:

NIC: ASUS XG-C100C mit aktuellstem Treiber von der Chiphomepage - ja ich weiß das ist kein Intel, was ich darüber aber gelesen hatte war vielversprechend. Es gibt Alternativen von Synology (E10G18-T1) oder Intel (X540), aber ich hatte nicht vor einen Riesentestbench aufzubauen.

Switch: Netgear XS708E, 8-Port 10GB

Verkabelung: CAT7 TP

Teststellung: 2 moderne PCs mit je einer ASUS-Karte verbunden mit dem Netgear, der wiederum mit einem Kabel auf einem Standard-GBit hängt um den Rest des Netzes zu erreichen / DHCP / ..

Ich tue mich nun sehr schwer den Durchsatz real zu bewerten.

Das Testtool 'Lanspeedtest' arbeitet in der Free-Version nicht zuverlässig und bevor ich das kaufe, wüsste ich gern ob es denn dann funktioniert.

"Netstress" hat eine Menge PArameter an denen ich drehen kann, ich bräuchte dafür aber sowas wie einen sinnigen PreSet für 10GB um das auswerten zu können.

SMB über FileCopy zwischen den PCs ist zu verwaschen, da gehen Befindlichkeiten von Windows und dessen Subsystem zu sehr ein.

Bottom Line erreiche ich bestenfalls 2GBit Durchsatz (mit obigen Tools zusammengewürfelt), aber das ist sehr unsicher.

IPERF/JPERF sind schon aussagekräftiger, ich komme aber auch hier nicht über 4GB

An den IP-Parametern zu drehen (Jumbo etc.) ist nicht sinnig ohne exakt zu wissen was was bringt.

Danke Euch vorab für den Input

Please also mark the comments that contributed to the solution of the article

Content-Key: 575242

Url: https://administrator.de/contentid/575242

Printed on: April 19, 2024 at 15:04 o'clock

21 Comments

Latest comment

Wenn beide Seiten SSDs verwenden kriegst du per cif oder smb locker 10GBit hin. Bist du sicher, dass du ein vernünftiges Kabel verwendest?

(Korrektur: Ich beziehe mich hier auf SSD Raids oder PCIE SSDs)

Ich hatte auch Probleme mit einem Cat6a Kabel. Dann habe ich vernüftige bestellt (glaube so 20€ für 3m) und damit hatte ich dann keine Probleme mehr. Ich traue den Hersteller Angaben daher inzwischen null. War beim Kabel ein Messprotokoll dabei?

Schau ma ins Ereignislog, ob da irgendwo ein Info Eintrag zum Ethernet Speed ist.

(Korrektur: Ich beziehe mich hier auf SSD Raids oder PCIE SSDs)

Ich hatte auch Probleme mit einem Cat6a Kabel. Dann habe ich vernüftige bestellt (glaube so 20€ für 3m) und damit hatte ich dann keine Probleme mehr. Ich traue den Hersteller Angaben daher inzwischen null. War beim Kabel ein Messprotokoll dabei?

Schau ma ins Ereignislog, ob da irgendwo ein Info Eintrag zum Ethernet Speed ist.

Ich tue mich nun sehr schwer den Durchsatz real zu bewerten.

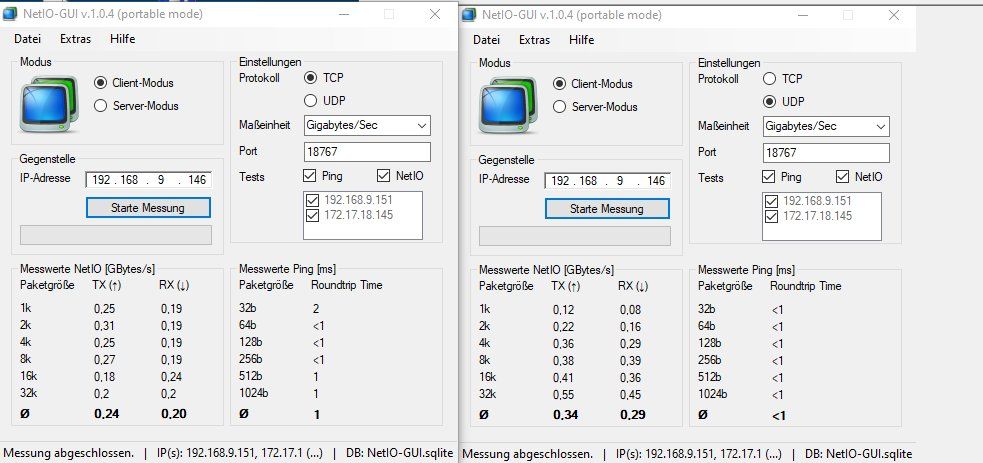

NetIO und IPerf3 sind deine besten Freunde !!!http://www.nwlab.net/art/netio/netio.html

Eigentlich kann das jeder Laie, denn man muss nur vom Bildschirm ablesen können !

Hab nochmal nachgeschaut was ich im Einsatz habe. Probiers mal mit dem Kabel:

TM31 Draka UC900

Ist ein Cat 7 Kabel mit Cat 6a Steckern.

https://www.reichelt.de/patchkabel-tm31-s-ftp-uc900mhz-grau-3-0m-patch-t ...

TM31 Draka UC900

Ist ein Cat 7 Kabel mit Cat 6a Steckern.

https://www.reichelt.de/patchkabel-tm31-s-ftp-uc900mhz-grau-3-0m-patch-t ...

Der Vollständigkeit halber möchte ich auch nochmal betonen, dass ich vorher Cat 6a zertifizierte Kabel mit Messprotokoll hatte. Auch 3m. Die Ports gingen ständig hoch und runter. Ein bloßes Anpacken / Wackeln am Kabel hat die Übetragung schon gestört. Nach dem Wechsel auf Draka war alles top. Mit Cat 8.1 habe ich noch keine Erfahrung gemacht. Berichte mal bitte die Unterschiede. Die Stecker müssen ja echt massiv sein.

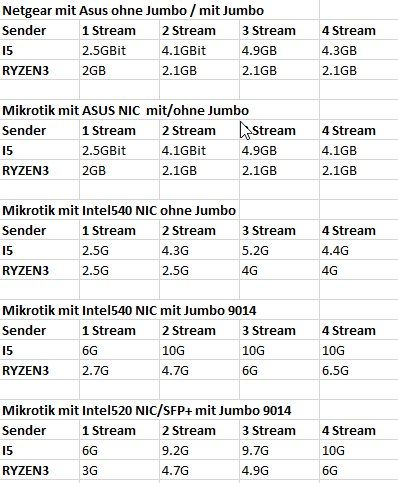

NETIO und JPERF melden unisono max. 4.3GBit.

- Bei welcher Paket Größe ?

- Welche Encapsulation ? UDP oder TCP ?

- Hast du (hoffentlich) Jumbo Framing auf dem 10G Switch aktiviert ??

Die Mikrotik 10G Switches CRS305 oder der CRS309 schaffen hier (gemessen mit NetIO) ca. 85% Durchsatz mit aktivem Jumbo Framing und DAC/Twinax bzw. LWL.

Vorsicht bei 10G Base T. Das ist im Gegensatz zu LWL oder DAC/Twinax immer ein Negotiation Verfahren. Eine zu große Länge, schlehcte Steckverbindungen, ein Knick im Kabel oder ein zu großer Biegeradius und schon kommen von den 10G nur noch 8, 6, 4 oder noch weniger Gig an. Der Switch negotiated pro Port dynamisch je nach Kabellänge und Qualität die maximal übertragbare Rate.

Ein gravierender Nachteil zu der o.a. 10G Infrastruktur die immer feste 10G garantiert.

Das ist der Grund warum Netzwerker in einer Server oder Storage Verkabelung mit garantierter Bandbreitenanforderung niemals zu 10GBase T mit RJ-45 greifen. Das ist da immer ein NoGo.

Das solltest du also auch auf dem Radar haben !

Jumbo kann ich auf dem Netgear nicht explizit einstellen, ist laut Netgear aber der Default.

Vertrauen ist gut, Kontrolle besser. Was sagt denn die aktuelle MTU auf dem Switchport ?Setzt ihr den Jumbo in der NIC-Konfig unter Windows manuell auf Maximum?

Bei 10G natürlich !Und bringt das wirklich so viel, Netgear z.B. sagt

Weltfirma NetGear die natürlich führende Erfahrungen im weltweiten Betrieb großer Rechenzentren hat. Sorry, aber was soll man auf Kommentare eines Herstellers im billigen Consumerbereich geben. Das ist natürlich Unsinn. Teste das doch ganz einfach selber. Ein Bild sagt mehr als 1000 Worte ! Werde nach dem Test berichten

Wir sind gespannt...

Passiert das auch mit aktiviertem Jumbo Framing ?

Das hier kennst du sicher dazu:

https://www.heise.de/tipps-tricks/DPC-Watchdog-Violation-so-beheben-Sie- ...

Es gibt tausende Hits wenn du nach dem Fehler suchst.

Es wäre ggf. sinnvoller die Tests nicht unter Winblows zu machen sondern iPerf3 auf Linux laufen zu lassen um diesen Fehler zu umgehen. Diverse Foren und auch die Microsoft Knowledge Base sprechen Probleme mit dem Schnellstart an die das auch verursachen können. Vielleicht nicht gerade die beste Plattform zum Testen. ggf. ist hier ein Live System wie Kali https://www.kali.org/ vom Stick gebootet besser. Das hat diese Tools alle an Bord.

Spannend wäre noch zu erfahren:

Das hier kennst du sicher dazu:

https://www.heise.de/tipps-tricks/DPC-Watchdog-Violation-so-beheben-Sie- ...

Es gibt tausende Hits wenn du nach dem Fehler suchst.

Es wäre ggf. sinnvoller die Tests nicht unter Winblows zu machen sondern iPerf3 auf Linux laufen zu lassen um diesen Fehler zu umgehen. Diverse Foren und auch die Microsoft Knowledge Base sprechen Probleme mit dem Schnellstart an die das auch verursachen können. Vielleicht nicht gerade die beste Plattform zum Testen. ggf. ist hier ein Live System wie Kali https://www.kali.org/ vom Stick gebootet besser. Das hat diese Tools alle an Bord.

Spannend wäre noch zu erfahren:

- Für welche Frame Größe hast du das getestet ?

- Welche Protokoll Encapsulation hast du verwendet ? UDP oder TCP

- iPerf3 Syntax ?

Nur TCP - UDP gab grottige Ergebnisse.

Was sehr sehr merkwürdig ist. Dadurch das das gesamte Handshaking bei UDP auf den Endgeräten wegfällt müsste die Durchsatzrate also signifikant höher sein... Komisch !Sonst mal testweise NeTIO im Vergleich nehmen:

http://www.nwlab.net/art/netio/netio.html

bzw. Download hier:

https://web.ars.de/netio/